KOMENTÁŘ RADKY TYPLTOVÉ | Poslankyně ANO Margita Balaštíková se pokusila nechat zabít psa exmanželovy přítelkyně. Dokazují to tajně pořízené nahrávky, jejichž pravost potvrdila soudní znalkyně. Přesto se Balaštíková zuby nehty brání a nahrávky opakovaně označuje za AI podvrh. Česká politická scéna je „napřed“: dříve než reálné AI manipulace tu máme výmluvy na ně. A příznivci ANO na ně s rozběhem skáčou. Říká se tomu „lhářská dividenda“ a v budoucnu to – vzhledem k nízké mediální gramotnosti Čechů – ještě bude nepochybně velký problém.

Když vyšlo najevo, že si poslankyně ANO, trojka na kandidátce

hnutí ve Zlínském kraji a ministryně zemědělství ve stínové

vládě chtěla objednat zastřelení psa přítelkyně svého

bývalého manžela, národ pejskařů povstal.

Chladným to

nenechalo ani Andreje Babiše, který se v roce 2023 v rámci kampaně

fotil s šestnáctiletým Lojzou z útulku, ani Karla Havlíčka,

jemuž erdelteriér Betyna v rámu mediálního obrazu nahrazuje

manželku.

Můžeme už jen

spekulovat, zda by podobný odpor se stejnými důsledky (stažení

Balaštíkové z kandidátky, ovšem nikoli požadavek na složení

aktuálního poslaneckého mandátu) vyvolalo i předchozí zjištění

o pokynu „zakleknout“ prostřednictvím hygieny na firmu bývalého

manžela a „poslat ji do kytek“.

Nahrávky jsou pravé, potvrdila znalkyně

Obě politicky i eticky třaskavé informace vyplynuly z nahrávek, které tajně pořídil Josef Balaštík, bývalý manžel poslankyně. Kauza ale začala rezonovat naplno až při zveřejnění konverzace s pokusem o objednávku likvidaci psa. V ten moment začaly bít na poplach nejen facebookové profily s psovitými šelmami na profilovce. Národ milovníků psů reagoval okamžitě, hromadně a nesmlouvavě.

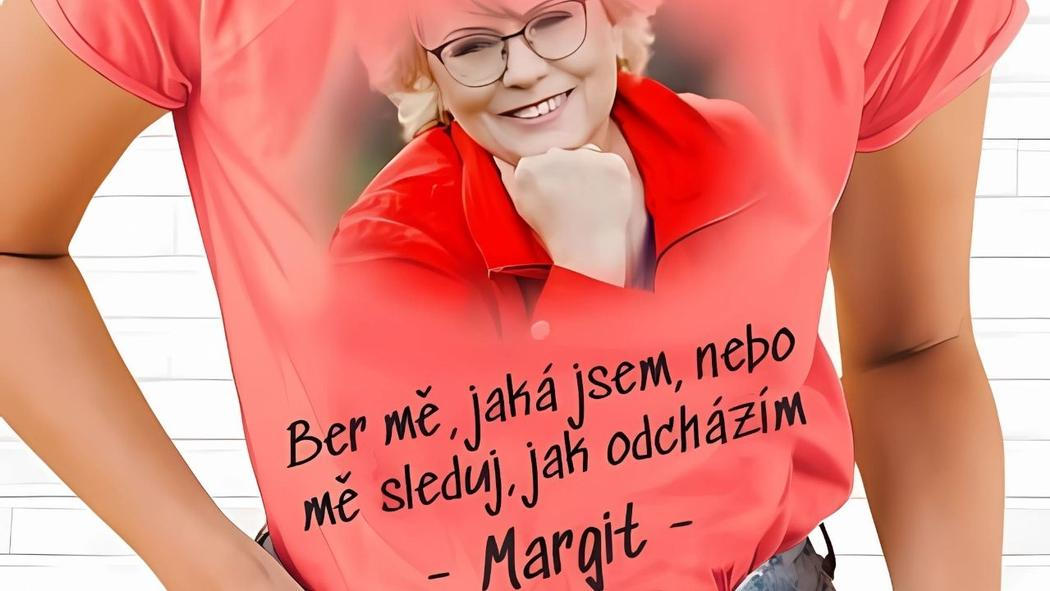

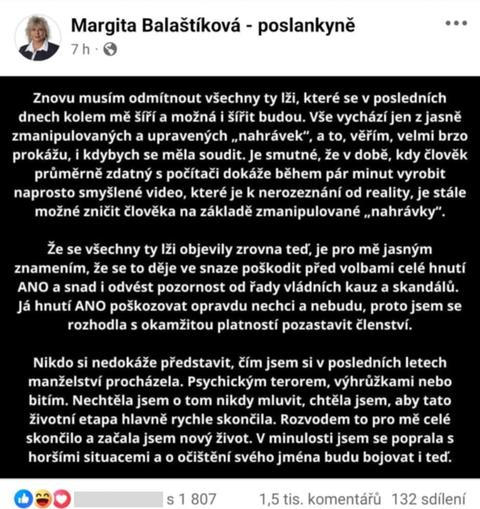

Margita Balaštíková pravost nahrávek popírá. V komentáři na své sociální síti uvedla, že důkazy jsou zmanipulované. Po pár dnech smazala nejen komentář, ale rovnou celý profil.

Advokát Josefa Balaštíka však nechal nahrávky posoudit renomovanou soudní znalkyní z oblasti audioexpertíz – fonoskopie, tedy identifikace mluvčího. Znalkyně Marie Hes Svobodová potvrdila jejich pravost.

„V záznamu nebyla nalezena

místa, která by jednoznačně svědčila o záměrné manipulaci s

cílem pozměnit obsah,“ napsala do posudku, z něhož citovaly Seznam Zprávy.

Na devíti

nahrávkách znalkyně jednoznačně identifikovala jako mluvčí

Margitu Balaštíkovou. Jako srovnávací materiál přitom použila

její vystoupení v České televizi. U dvou nahrávek označila

mluvčí jako „s nejvyšší pravděpodobností“ totožnou s

Balaštíkovou, u třech nahrávek pak jako „pravděpodobně

totožnou“. Jedná se o čtyři nejvyšší hodnocení na znalecké

stupnici určování osob mluvčích, shrnuje web Seznam Zprávy.

Na scénu tak přichází paradox: realita je označena za podvrh. Nikoho to ale příliš nevzrušuje. Češi se stejně rádi pohoršují, jako smějí. Vznikla proto spousta satirických koláží a memů, které okamžitě zaplavily veřejný prostor. A jak rychle zájem a pobouření přitekly, tak rychle i odtekly.

Přesto by pod lupou, kromě samotného faktu, že takto neakceptovatelně jedná „elita národa“ – žena, která reprezentuje hnutí ANO v Poslanecké sněmovně už dlouhých 12 let – měla zůstat nejen její lež, ale i role AI jako nástroje k popření pravdy.

Fenomén „lhářské dividendy“

Američtí právníci Bobby Chesney a Danielle Citron označili tento jev – scénář, kdy šíření informovanosti o dostupnosti deepfake umožňuje obviněným tvrdit, že kompromitující obsah je jen podvrh, a vyhnout se odpovědnosti – jako „liar's dividend“ = „lhářská dividenda“.

Vědecká studie zkoumající vzorek 15 tisíc Američanů ukázala, že když politici označí své skandály za „fake news“ či „deepfake“, dokáže to zvýšit jejich podporu, přestože jsou původní tvrzení reálná. Zmatená veřejnost je podle vědců v divokých časech AI náchylnější k odmítání autentických záznamů.

A jak se generovaná média (AI, deepfake) stávají sofistikovanějšími, roste i možnost odkladu odpovědnosti. „Lhářská dividenda“ ale v důsledku vede k erozi důvěry jako takové.

Příznivci Margity Balaštíkové z řad voličů ANO měli každopádně jasno. Pod postem na Facebooku (viz výše) se objevila spousta komentářů. Nemálo z nich jí vyjadřovalo podporu a víru ve zmanipulování nahrávky.

Jak se bránit AI podvrhům naopak?

Deepfakes jako takové získávají na popularitě i v politické sféře. V září 2023 se virálně šířil falešný zvukový klip, na kterém Michal Šimečka, lídr prozápadní strany Progresivní Slovensko, diskutuje s novinářem o tom, jak zmanipulovat volby.

Objevily se deepfake nahrávky Joea Bidena i Donalda Trumpa, ale například i českého prezidenta Petra Pavla, který o nich natočil edukativní video.

Tyto případy budou nepochybně narůstat. K obraně proti podobnému jednání je klíčová mediální gramotnost veřejnosti. Lidé musí pochopit, že podvrhy sice existují (a umět je v rámci možností rozpoznat), ale zároveň mít na paměti, že ne každé nepříjemné tvrzení je nutně podvrhem. Je potřeba uplatňovat kritické myšlení, nikoli relativizaci reality ve smyslu „všechno může být falešné“.

Klíčem je odpovědnost a ověřování faktů

Soudy, média a další instituce by měly jasně komunikovat, jak ověřují autenticitu, například prostřednictvím nezávislých expertíz, digitálních podpisů, skrze metadata...

A v neposlední řadě, pokud někdo záměrně zpochybní autentický důkaz jako AI podvrh, musí existovat mechanismy (morální i právní), které ho za to poženou k odpovědnosti. Jinak se nám tu se lhářskými dividendami roztrhne pytel, který už těžko půjde „zalátat“.

Největší hrozbou už dnes nejsou deepfakes samotné, ale to, že jejich existence oslabuje schopnost rozlišovat mezi skutečností a fikcí. A dává prostor cynickému popírání.

Případ Balaštíkové je alarmující ilustrací. Popírání autenticity záznamů a označování reality za AI podvrh může do aktuálního informačního chaosu zasít další semínka pochybností. Jde přitom o velmi invazivní druh, jak je patrné i bez AI.

🔥🗞️ Přidejte si INFO.CZ do svých oblíbených zdrojů na Google Zprávy. Díky.